Обзор на Google – януари 2025

Google с актуализация на Site Reputation Abuse Policy

Екипът на Google съобщи за актуализация на политиката за злоупотреба с репутация на сайтове (site reputation abuse policy). Целта е да улесни намирането на ключова информация, свързана с препоръките на Google.

Тези промени не са свързани с нови правила и изисквания към собствениците на сайтове. Това са допълнителни уточнения за това какво да правите, ако в сайта ви има съдържание от трети страни, което може да нарушава политиките. Ето и какво да правите, за да отговорите на политиката на Google и да не бъдете засегнати от ръчни действия.

Накратко, ако имате страници със съдържание, което нарушава политиките, Google препоръчва да използвате noindex таг за тези адреси, за да забраните обхождането им, или да преработите съдържанието.

Силно непрепоръчително е преместването на съдържанието в нов домейн или поддомейн, тъй като Google може да го приеме като опит за заобикаляне на правилата и да предприеме по-сериозни мерки.

Повече информация за това съдържание и къде точно се показва можете да получите в Google Search Console Center, в Manual action report или по имейл.

Колко точно URL адресите помагат за SEO?

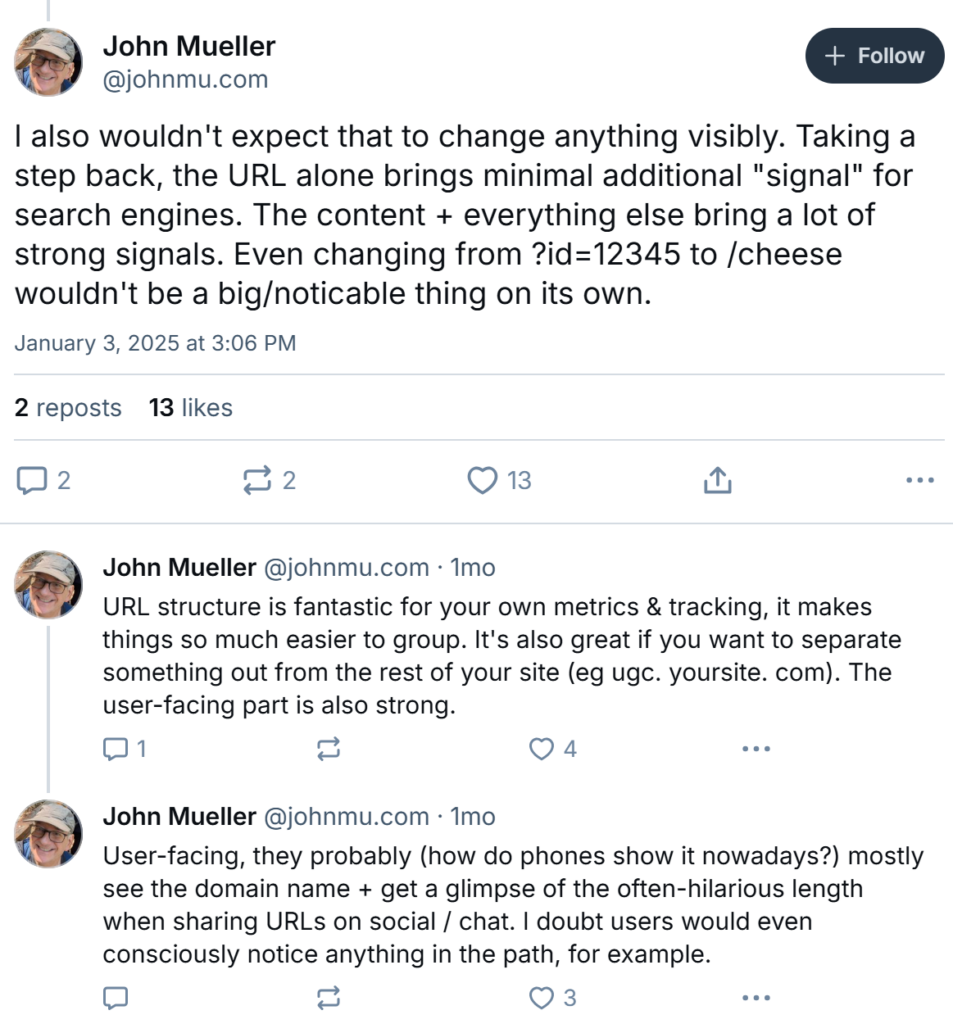

URL адресите и тяхната структура винаги са били тема за SEO специалистите, която поражда въпроса – колко важни са те и оказват ли влияние от гледна точка на SEO. И днес продължава да е причина за дискусия.

Неведнъж екипът на Google е заявявал, че добавянето на ключови думи в самия URL адрес не означава, че страницата ще се класира по-добре. През изминалия месец John Mueller няколко пъти говори за URL адресите. Той отново потвърди, че те носят минимална допълнителна стойност и не са важен сигнал за търсачките. Също така добави, че промените на URL адресите, като например “от ?id=12345 на /cheese” няма да е ключова промяна.

Друго питане към John Mueller гласеше дали има проблем да се използва mydomain. com/shoes-es вместо mydomain. com/shoes/es.

В отговор John заяви, че това няма да доведе до каквито и да е било промени в класирането, а по-скоро ще се видят временни колебания, именно заради направената промяна в структурата на URL.

В случаи на локализации, той препоръча използването на ccTLD (country code top level domain), с което да се разграничат различните държави. Напомняме, че ccTLD е домейн от първо ниво, който указва към коя държава принадлежи.

Накратко, изграждането на добра URL структура е чудесна за целите на бизнеса и за лесно проследяване, но няма да е нещо, което да окаже съществено влияние на страницата и целия сайт като цяло.

Най-важно за търсачката си остава ясно обособена архитектура в сайта и създаване на качествено съдържание, с което да давате повече стойност на потребителите.

Google Search Console с нова функция за отчетите

Екипът на Google съобщи за актуализация в Performance отчетите. През декември една от новостите бе пускането на функцията за изглед на данните за последните 24 часа. Много от SEO експертите се зарадваха, тъй като дава допълнителен поглед върху представянето на уебсайта за по-кратък период от време, като този за последното денонощие.

Във връзка с получената положителна обратна връзка, компанията реши да добави и опцията за експорт на тези данни за последните 24 часа.

Какво казва Google за Generative AI?

Темата за AI и генеративният изкуствен интелект се очертава да бъде сред топ дискусиите и през тази година. От това, което до този момент сме научили, е, че Generative AI е вид изкуствен интелект, който се използва за генериране на съдържание под формата на текст, изображение, видео и други.

В тази връзка John Mueller сподели, че използването на генеративен изкуствен интелект за създаване на блог публикации и всякакъв друг тип съдържание с цел получаване на backlinks е против политиките за спам на Google. Това означава, че при такова нарушение сайтът ви може да бъде наказан.

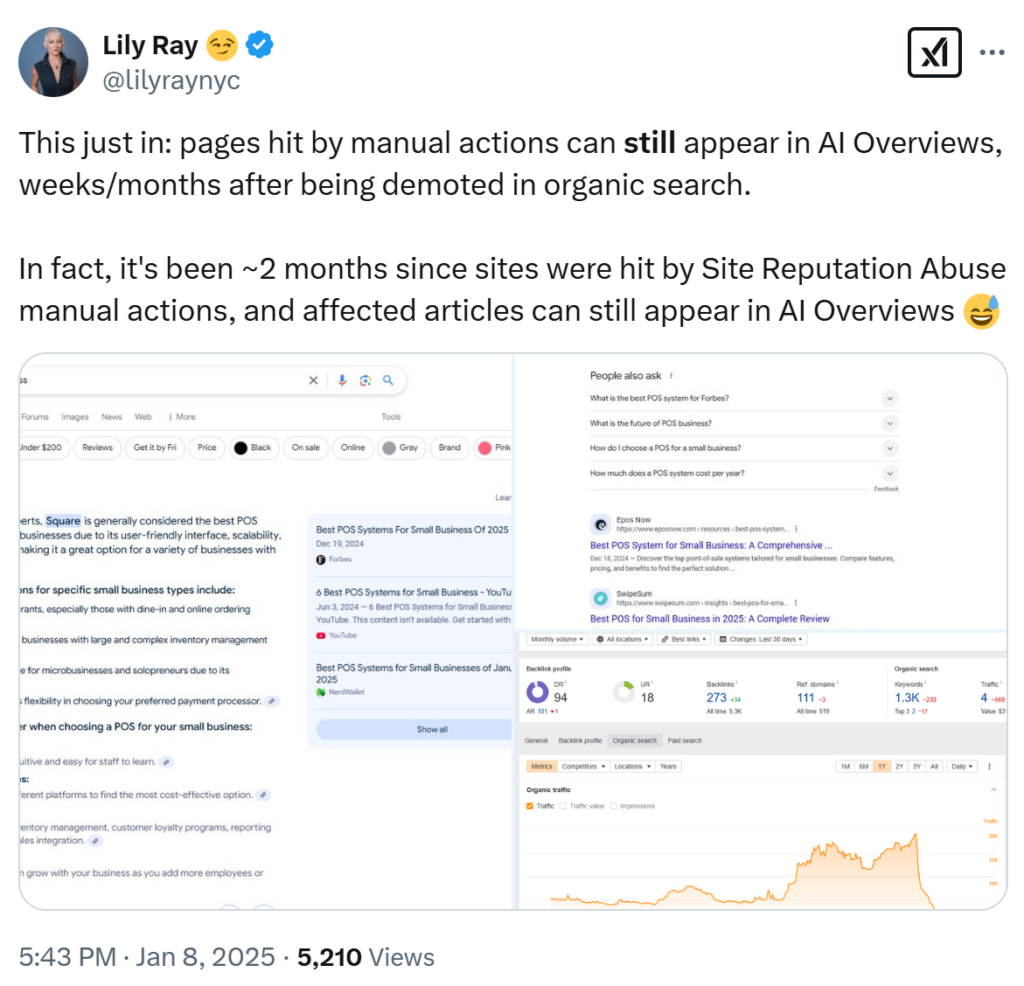

Google показва в AI overviews уебсайтове, засегнати от ръчни действия

Това забеляза и сподели Lily Ray, която е SEO експерт. От публикацията ѝ става ясно, че е забелязала как сайтове, които от около преди 2 месеца са били засегнати от Site Reputation Abuse manual actions, все още се появяват в резултатите, но в секцията AI overviews.

Това потвърди и Glenn Gabe, който също е специалист в SEO индустрията. Според него е твърд вероятно Google да адресира това и да вземе мерки, но тепърва предстои да разберем.

Google: Не актуализирайте вашия robots.txt динамично

Кога и колко често да актуализирате robots.txt файла е въпрос, който SEO специалисти и собственици на бизнеси си задават. В тази връзка SEO специалист сподели, че обмислят дали е добра практика, ако се качи един robots.txt файл сутрин, за да блокират Googlebot, и да качат друг следобед, с който да позволят на ботовете да обхождат сайта.

В отговор John Mueller беше категоричен, че това е лоша практика, тъй като robots.txt може да бъде кеширан до 24 часа. Той силно не препоръчва взимането на подобни действия и то в рамките на един ден. По-скоро посъветва да използват 503 и 429 status code в случаите, когато обхождането е твърде често.

Google актуализира Quality Raters Guidelines

В края на месец януари екипът на Google направи актуализация на още една своя документация – Quality Raters Guidelines. В нея са актуализирани секциите за страници с ниско качество, така че да отговорят по-добре на политиките за Google Search Web Spam. Също така има добавени насоки за оценка на интерпретации, добавени са нови примери и са разяснени някои формулировки, за да бъдат по-лесно разбираеми и приложими.

Google: Сливането на съдържание може да бъде предизвикателство

SEO експерт сподели, че е обединил съдържание и е направил 301 редирект към тази, която е оставил. Това, което го е притеснило, е, че все още вижда старата страница.

В отговор John Mueller каза, че сливането на съдържание и две страници е малко по-предизвикателно, отколкото просто преместване на сайт. Той добави, че би дал малко време и би бил търпелив. Също така каза, че дори и ако преместим сайта и ако потърсим конкретния стар URL адрес, Google ще ни покаже, защото търсачката разбира, че ние знаем какво точно търсим, и ни го предоставя.