Обзор на Google – Декември 2022

Нова глобална актуализация на Google Helpful Content

Започваме новия обзор с новината, че през декември Google официално обяви пускането на новата актуализация за полезно съдържание – Google Helpful Content Update.

Целта на актуализацията е да открива съдържание, което е създавано единствено и само с цел да се класира добре, но не е полезно за потребителите, както и съдържание, което е ниско качество или не е оригинално.

Актуализацията не засяга само съдържанието на английски език, а напротив, тя се отнася до всички езици на глобално ниво.

Google пуска нова актуализация на Link Spam със SpamBrain AI

Още една важна актуализация, за която Google ни съобщи през декември, е тази на Link Spam, която използва Spam Brain AI. Google обясни, че това е система за предотвратяване на спам, която е базирана на изкуствен интелект.

С нея се цели да се неутрализира въздействието на неестествените линкове върху резултатите от търсене в Google. Тази система помага на Google да открива не само спам, но и сайтове, които купуват линкове.

В своето съобщение Google сподели, че пускането на актуализацията ще бъде за всички езици, като може да отнеме около две седмици. Към това допълни, че този ъпдейт може да окаже влияние върху класирането, тъй като ще неутрализира всички неестествени линкове.

Google: URL адресът не е необходимо да бъде на същия език като този на самата страница

Alan Kent от Google именно това сподели, казвайки, че не е задължително URL адресите във вашия сайт да бъдат на езика, на който е съдържанието в тях. Към това Google допълни, че от гледна точка на SEO по никакъв начин няма да повлияе това, че езиците на адреса на страницата и съдържанието вътре в нея са различни.

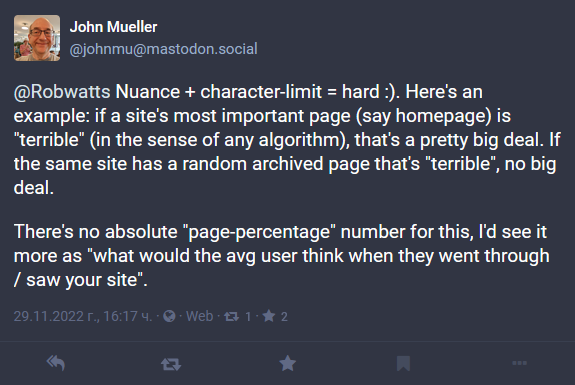

Ако най-важната страница във вашия сайт не се представя добре, това оказва влияние от гледна точка на SEO

John Mueller от Google коментира, че ако най-важната за вас и вашия сайт страница няма добро представяне в Google и има сериозни проблеми в нея, това ще бъде огромен проблем за представянето на вашия сайт и като цяло от гледна точка на оптимизация. Той допълни, че това не се отнася за страниците, които са по-малки и не толкова важни.

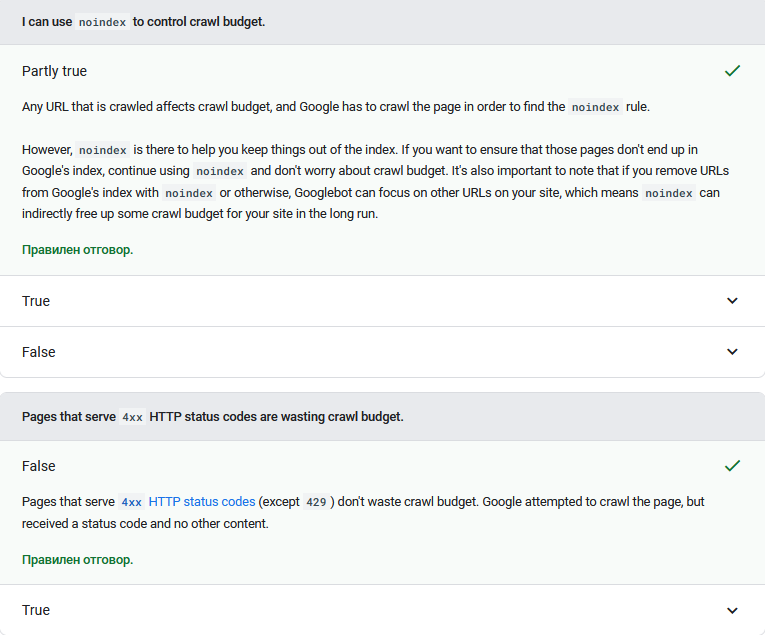

Google актуализира своя документация, разяснявайки използването на noindex и 404 за оптимизиране на crawl budget

В своята помощна документация Crawl Budget Management For Large Site Google добави два въпроса с отговор на тях. В нея се казва, че използването на <noindex> с цел да се контролира crawl budget до някъде може да помогне, но не съвсем. Google допълва, че е добре да използваме тага в случаите, когато искаме да сме сигурни, че дадена страница не трябва да се индексира.

Втората актуализация в документацията е свързана с това, че страниците с 4xx статус код не хабят от вашия crawl budget. Изключение са страниците със статус код 429.

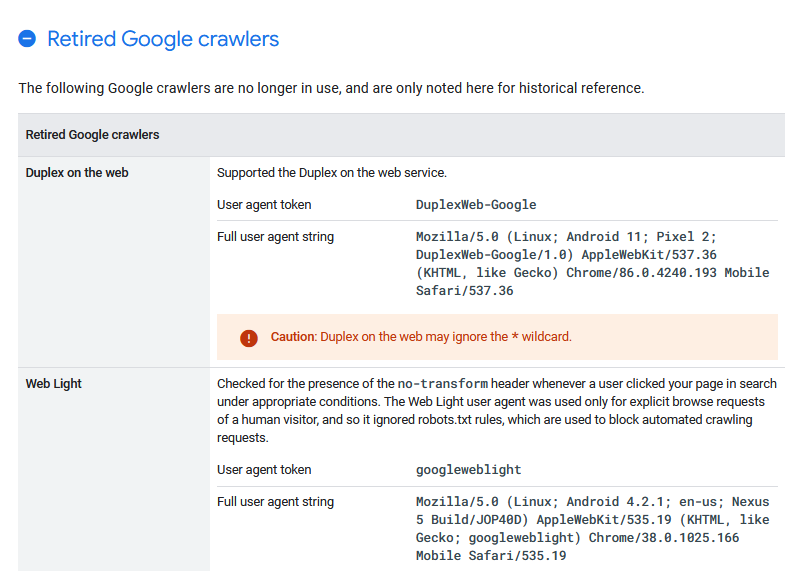

Нова секция в помощната документация за Google Crawler (User Agent)

Google добави нова секция в своята документация за Google Crawler, в която може да направите справка относно кои обхождащи агенти на Google вече не функционират. Името на секцията е Retired Google crawlers, а това, което стана ясно през месец декември, е, че Google спира DuplexWeb-Google User Agent.

Сайтове, които използват Subscribe With Google могат да наблюдават увеличение на импресиите и кликванията

Google добави съобщение към Performance отчетите в Google Search Console, казвайки, че сайтовете, които използват Subscribe With Google може да наблюдават увеличение на кликовете и импресиите.

Актуализирайте датата на дадено съдържание в случай, че промените в него са големи

В края на 2022 година пред създателите на съдържание възникна един важен въпрос, а именно съдържание, което актуализират за 2023 година дали трябва да актуализират и неговата дата.

По тази тема John Mueller сподели, че датата трябва да се актуализира единствено и само ако има значителни промени в самото съдържание. Ако редакциите са малки, то не е необходимо да актуализирате датата. Той допълни, че често вижда сайтове, публикуващи съдържание с ниско качество или такова, което е спам, как актуализират датите си, а това със сигурност не е добра практика.

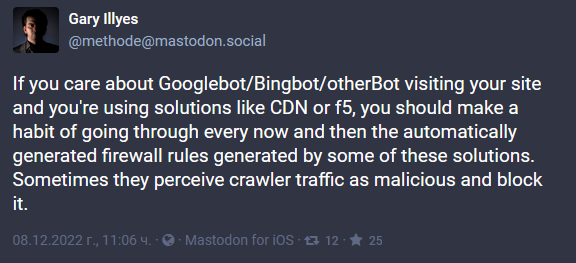

Google: При използването CDN или облачен хостинг тествайте дали услугата не блокира Googlebot

Gary Illyes от Google сподели в Mastodon, че е от съществено значение периодично да проверявате така наречените firewall rules, генерирани от решения като CDN и облачни хостинг услуги. Причината периодичните проверки да са толкова важни е, че този вид услуги понякога могат да възприемат Googlebot като злонамерен и да го блокират.

Създавайте разнообразно съдържание, написано за вашите потребители

Именно такъв е съветът, който Danny Sullivan от Google дава и е повтарял неведнъж. Неговият коментар бе относно публикация на Mastodon, където потребител сподели своя блог статия на тема “Google’s Helpful Content Update: What it means for nicheless blogs”.

В отговор Danny Sullivan каза, че не е необходимо съдържанието, което създавате, да бъде за една ниша и на една и съща тема, за да може да се класира добре при търсене в Google. Той допълни, че можете да създавате разнообразно съдържание, което да бъде на различни теми.

Това, което е по-важно за Google, е да създавате съдържание, което е специално предназначено за потребителите, а не за търсачките. Създавайте текстове, които носят полезна информация на потребителите и дават стойност. Именно това е нещото, което отличава качественото съдържание.

Неведнъж сме споделяли всичко това, а и Google често ни го напомня, именно защото е от изключителна важност и носи стойност.

Времето, което се прекарва на дадена страница в сайт не е фактор за класиране

John Mueller от Google отново ни напомни, че за Google времето, което потребителите прекарват на определена страница от даден сайт, не е фактор за класиране. Това напомняне дойде, след като SEO специалист попита защо Google Search Console Insights не показват какво е времето, което потребителите са прекарали на страниците от съответния сайт.

Google: Забраняването на Googlebot да обхожда вашия сайт не е начин за деиндексирането му

Ако търсите начин, по който вашият сайт незабавно да бъде деиндексиран, то забраняването на Googlebot да обхожда вашия сайт не е решение. Именно това ни напомни John Mueller от Google. Той допълни, че отпадането на един сайт от индекса отнема време, като в някои случаи началната страница може и да остане.

Google добавя още едно E към E-A-T

Google обяви, че добавя още едно E към E–E-A-T за Experience, като по този начин абревиатурата означава Experience, Expertise, Authoritativeness и Trustworthiness. Към това Google допълни, че E-E-A-T вече е част и от документацията с насоки за оценяване качеството.

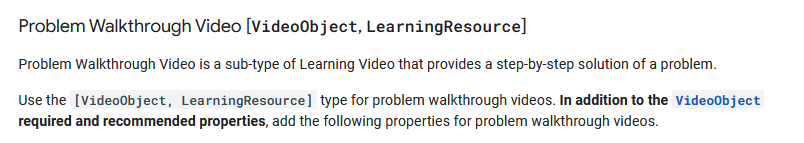

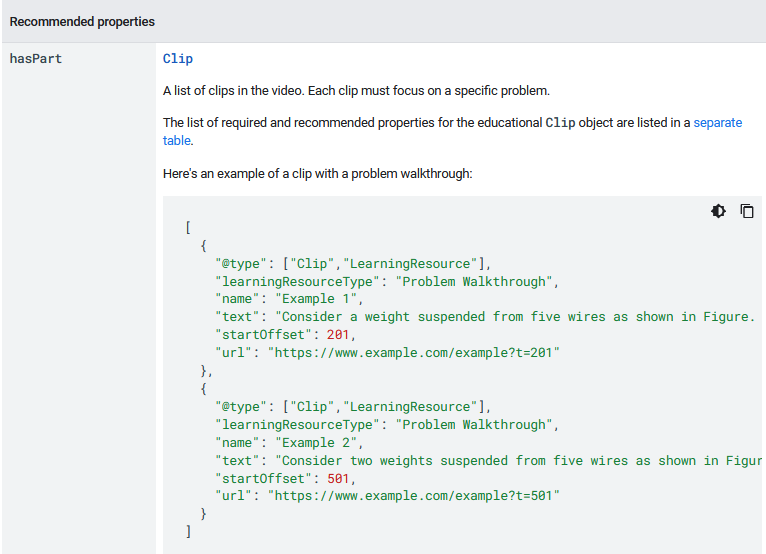

Google препоръчва използването на текстовото поле за структурираните данни на Google Learning Video

През месец декември Google актуализира и документацията си за структурираните данни за learning video, като в нея посочва, че не е задължително да използвате текстовото поле за проследяване на проблеми с видеата и тяхното разрешаване, а само се препоръчва.

XML sitemaps не заповядват на Google, а само му подсказват кои са нашите URL адреси

Бързо напомняне дойде през декември от Gary Illyes от Google. Той ни припомни, че XML sitemaps не служат, за да “заповядват” на Google да индексира и класира всички страници, кито сме посочили в XML файла. Както той написа в своята публикация, това е “чудесен начин да разкажем на Google за URL адресите в нашия сайт”.

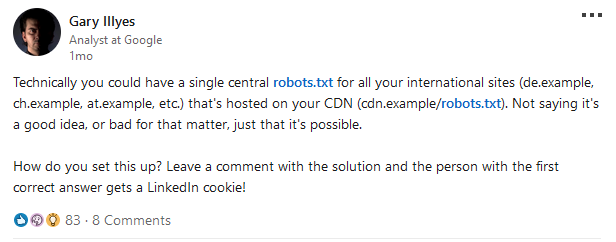

Google: Технически е възможно да използвате един общ robots.txt за всичките ваши международни сайтове

Gary Illyes от Google сподели, че е възможно да използвате един robots.txt за всички ваши международни сайтове (de.example, at.example, pl.example и т.н.), в случай, че имате такива. Той обаче допълни, че не казва по никакъв начин дали това е добра или лоша идея, а споделя единствено и само факта, че от техническа гледна точка е напълно възможно да се приложи.

Броят думи в една секция не е фактор от гледна точка на SEO

John Mueller сподели, че алгоритмите за класиране в резултатите от търсене на Google не вземат предвид броя думи, които има в разделите на страниците от вашия сайт. Той допълни, че това не е фактор от гледна точка на SEO и класиране на вашия сайт. От гледна точка на user experience със сигурност кратките параграфи са лесно четими и помагат за по-лесното проследяване на съдържанието от потребителите.

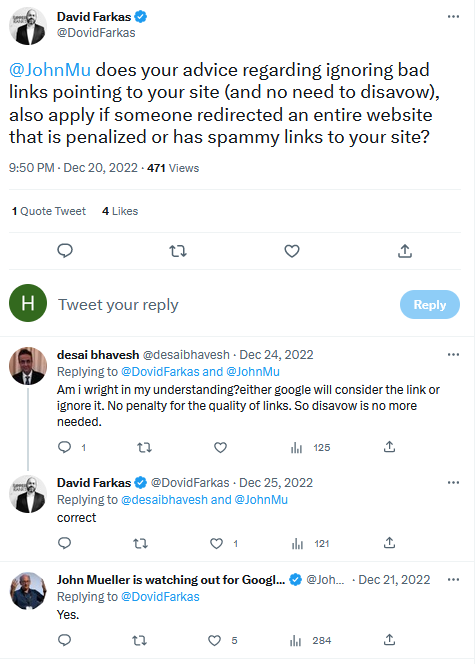

Google: Можете да игнорирате лошите връзки, сочещи към вашия сайт, дори и ако целият е наказан

След като Google пусна версия 4.0 на алгоритъма Penguin, вече не е необходимо да забранявате лошите линкове на вашия сайт, тъй като с помощта на новата актуализация те сами се неутрализират и понижават. Това означава, че не могат нито да ви навредят, нито да ви помогнат, или с други думи Google ще ги игнорира. Именно това потвърди и John Mueller на въпрос в Twitter.

Ако вашият сайт е негативно засегнат от Spam Update, не се дължи на дублирано съдържание

John Mueller сподели, че ако вашият сайт е по някакъв начин негативно засегнат от Spam Update, то това се дължи на нещо много повече и по-сериозно от дублирано съдържание и технически грешки.

Създаването на уникален текст с инфографики и видеа не прави съдържанието полезно

Връщаме се отново на темата за създаване на съдържание, като на въпрос към John Mueller той сподели, че това да напишете уникален текст, към който да добавите релевантни инфографики и видеа, не означава, че съдържанието е качествено и полезно за аудиторията. Изисква се много повече от това.

Важно е да обърнете внимание на фактологията и да създадете съдържание, което да предоставя полезна информация, да помага на потребителите, да бъде лесно разбираемо и още много други.

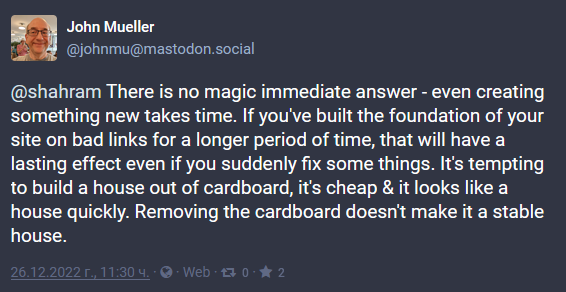

Google: Изграждането на сайт върху лоши линкове ще окаже негативно влияние в дългосрочен план

John Mueller потвърди, че може да усетите негативно влияние върху вашия сайт, ако е изграден на лоши линкове. Този ефект в повечето случаи остава за дълъг период от време.

Добър избор ли е използването на думата “тук” или “here” като анкор текст?

Lizzi Sassman от Google сподели, че използването на думите “тук” или “here” като анкор текст не са препоръчителни.