Обзор на Google – Февруари 2023

Новата актуализация на Product Reviews за февруари е вече налична

През последния месец Google пусна шестата актуализация на Product Reviews, за което обяви и в Twitter. Актуализацията обхваща няколко езика, включително английски, немски, френски, италиански, испански, португалски, холандски, полски, виетнамски, индонезийски и руски. Като повечето други актуализации на Google и в този случай пускането на февруарския Product Reviews Update отнема около 2 седмици.

Какво съветва Google за sitewide footer линковете?

В повечето случаи sitewide footer линковете се възприемат като спам. Именно затова и такъв въпрос имаше към Google в един от епизодите на English Google SEO office-hours, в който потребител попита какво да прави със sitewide footer линкове, които сочат към компаниите на дизайнери или CMS и дали са зловредни от гледна точка на SEO.

В отговор Lizzi Sassman от Google каза, че ако имате контрол върху тези линкове, препоръките са да добавите <nofollow> таг, както и да избирате релевантни анкори. Към това допълни, че не е препоръчително да се използват анкори, богати на ключови думи, и то безпричинно.

Google: Верификацията в Google Search Console не помага за по-доброто класиране на вашия сайт

Gary Illyes от Google заяви, че верифицирането на вашия сайт в Google Search Console няма да повлияе по никакъв начин на индексирането или класирането в Google Search.

Към това Gary Illyes добави, че целта на Search Console е да ви предостави данни и анализи относно това как вашият сайт се справя и има ли технически проблеми, на които да обърнете внимание. Това би помогнало да работите върху неща от SEO, които ще помогнат за по-доброто класиране в Google Search.

John Mueller от Google също е споделял, че от гледна точка на обхождането на един сайт, верификацията в Search Console няма да помогне.

Firewalls и проблемите със CDN най-често причиняват блокиране на Googlebot

Именно това сподели Gary Illyes от Google в своя публикация в LinkedIn. Това, което каза, е, че по негови наблюдения неправилната конфигурация на така наречените firewalls или CDN са най-честата причина за това да се блокира Googlebot, така че да не може да обходи вашия сайт.

В тази връзка той отново посъветва да проверявате какви са правилата за блокиране, за да сте сигурни, че няма да попречите на обхождането на вашия сайт, което съответно може да създаде сериозни проблеми в бъдеще.

Google актуализира документацията за канонизация

Както сме споделяли в нашата терминология с важни SEO термини, canonical тага е изключително важен от гледна точка на оптимизацията на вашия сайт, тъй като с негова помощ можете да се справите с дублираното съдържание на вашия сайт, особено когато има основна категорийна страница и подстраници към нея.

През месец февруари Google направи актуализация на документацията Canonicalization Help Documentation и съдържанието в нея, така че да предостави максимално ясна и детайлна информация относно това как работи търсенето в Google, както и какво представлява канонизацията и всичко около нея.

Към този момент помощният документ съдържа три основни раздела:

- Какво представлява канонизацията?

- Как да посочите rel=“canonical“ и използването на други методи

- Отстраняване на проблеми, свързани с канонизацията

Google поддържа структурираните данни във форматите JSON-LD, Microdata и RDF

Именно това ни каза Google – форматите JSON-LD, Microdata и RDF са поддържани за целите на структурираните данни и работят добре за Google Search. Разбира се, от съществено значение е да бъдат правилно реализирани.

GoogleProber и GoogleProducer са легитимни user agents на Google

Това потвърди John Mueller, след като потребител отправи въпрос към Google в Twitter. В тази връзка John каза, че GoogleProber и GoogleProducer са легитимни user agents и crawlers на Googlebot, които са характерни за конфигурацията на Google News в Publisher Center. В тази връзка, за да не срещате проблеми, е важно да не ги блокирате.

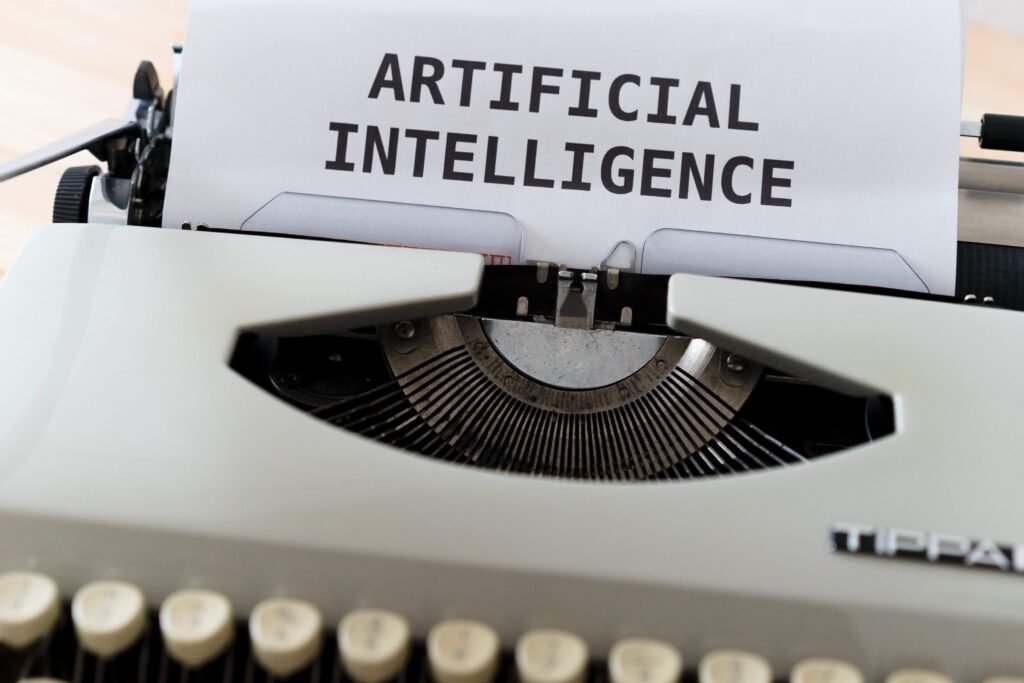

Google относно съдържанието, създадено с изкуствен интелект

Неведнъж вече сме споменавали за създаването на съдържание с изкуствен интелект, а в Обзора за януари 2023 коментирахме какво казва John Mueller относно ChatGPT и използването му за създаване на title tags.

От гледна точка на създаването на съдържание, Danny Sullivan от Google отново каза, че Google няма нищо против това да пишете съдържание с помощта на AI, стига то да е създадено за потребителите и да им бъде полезно.

В случай, че целта е просто да създавате голям обем от така нареченото “thin content”, което не носи стойност на вашите потребители, трябва да знаете, че това е против правилата на Google и най-вероятно ще бъдете наказани и страницата няма да се класира добре. Или с други думи, Google знае, когато се опитвате да го манипулирате.

Google актуализира документацията за Circumvention Spam

През месец февруари Google обръща специално внимание на своите документации, стараейки се да ги направи максимално лесни за разбиране и да добавя детайлна и полезна информация в тях.

В тази връзка Google направи леки корекции в документацията, кръстена Circumvention Spam Policy, така че да я направи максимално разбираема и да уточни някои важни неща.

Напомняме, че в нея Google казва, че ако сте извършвали и продължавате да извършвате действия, които целят да нарушат и заобиколят правилата на политиката за спам или тази за съдържанието в Google Search, Google може да предприеме действия, с които да ограничи или премахне правото ви на достъп до определени функции.

Някои от най-често срещаните заобикаляния и нарушения на правилата са създаването и използването на много сайтове, така че да продължите да нарушавате правилата на Google, както и използване на различни методи, чиято единствена цел е да се разпространява съдържание и да се предприемат действия, които са в разрез с политиките на търсачката.

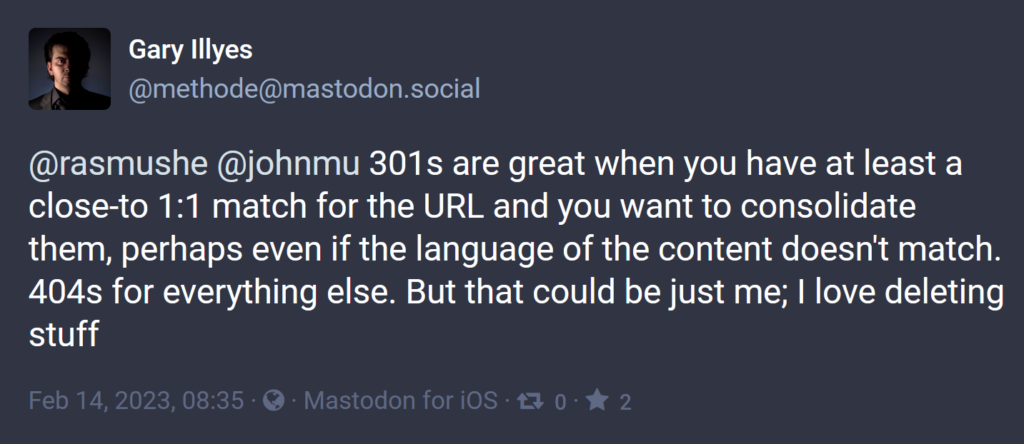

Google за 301 редиректите

Gary Illyes сподели в Mastodon, че 301 редиректите са страхотно решение, когато има изцяло или почти цяло съвпадение на URL адреса и целта на този редирект е да ги обедините. Той коментира, че това се отнася и за URL адреси, в които съдържанието е на различни езици. Така, например, ако имате URL A на български, а URL B на английски, можете да използвате 301 редирект.

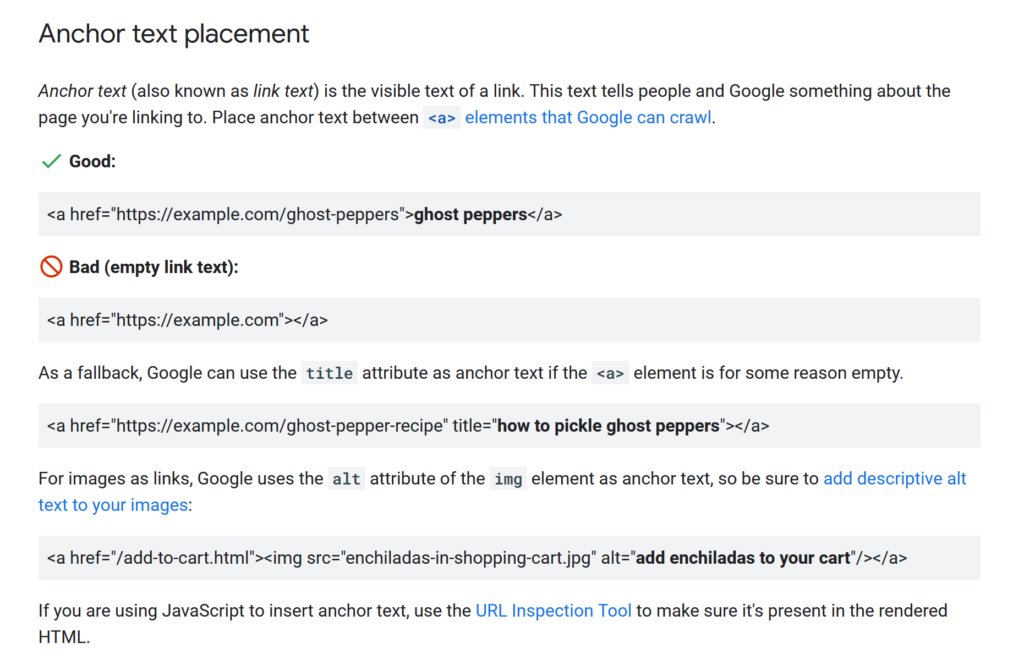

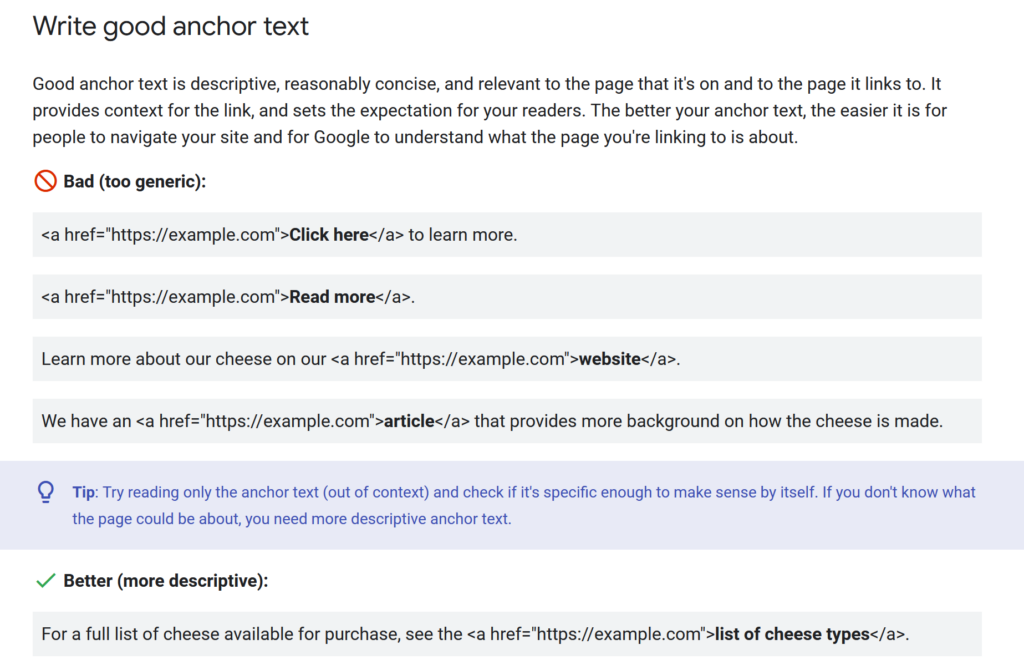

Google публикува нови най-добри практики за линковете

Този месец Google сподели нови най-добри практики за използването на връзките от гледна точка на SEO. Сега в документацията няма само информация относно това как да направите линковете достъпни за обхождане, а има и съвети за това къде да поставите анкора, как да създадете хубав анкор текст, създаването на вътрешни линкове в съдържанието и създаването на външни връзки от други сайтове.

Ето и малка част от документацията и актуалните съвети на Google:

Google: Не всички Googlebots използват един и същ rendering engine за JavaScript

John Mueller каза, че не всички ботове на Google използват един и същ rendering engine и като цяло не е необходимо всички да извършват rendering, включително и тези, за които е документирано, че го правят.

Използването на 4хх с цел да се ограничи обхождането на Googlebot е грешка

Gary Illyes публикува в блога на Google Search Central, че използването на 4хх, за да се ограничи честотата на обхождане на даден сайт от Googlebot, е грешен подход. Той посъветва всеки собственик на сайт или SEO специалист да спре да го прави.

Тази публикация идва след като екипът на Google забелязва през последните месеци такава тенденция. Gary Illyes напомни, че има документация, в която е описано какви са практиките за намаляване скоростта на обхождане от Googlebot. Той категорично заяви, че използването на статус 4хх няма да помогне за намаляване на скоростта.

Google относно <noindex> с редиректи

Потребител отправи въпрос към Gary Illyes, в който пита дали директиви, които са <noindex> и <nofollow> от URL адрес, който пренасочва, ще бъдат спазени или игнорирани. Към това той допълни, че noindex, nofollow се намират в HTTP заглавието, така че няма да е необходимо обхождане на HTML-а, за да се видят тези директиви. В отговор Gary Illyes каза, че според него не трябва да препращаме noindex с редиректи, освен ако не сме напълно сигурни.

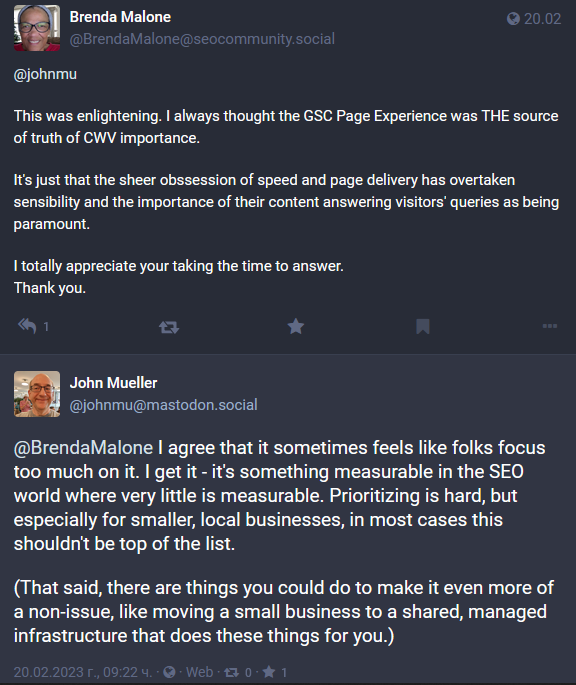

Колко важно е Core Web Vitals за малките и локални бизнеси?

В Mastodon беше зададен въпрос на John Mueller, който се отнася за малките сайтове, които имат по-малко 1000 страници. Темата бе за Core Web Vitals и това, че Google Search Console показва метриките на CWV и Page Experience само, когато има достатъчно данни от CrUX (Chrome User Experience Report ).

В тази връзка потребител, собственик на сайт, попита John дали малките сайтове трябва да се притесняват за Core Web Vitals предвид, че сайтът е малък, няма достатъчно данни и бизнесът не е толкова голям, за да си позволи услугите на разработчици.

В отговор John Mueller каза, че не е определящ фактор това, че даден сайт е малък и допълни, че CrUX използва други критерии. От гледна точка на това дали трябва да се подобрява скоростта на сайта, John написа “Може би.”, допълвайки, че потребителите ще го забележат, и ако сайтът е много бавен, те няма да остават на него.

Ние ще допълним, че скоростта на сайта е от изключителна важност за доброто представяне на вашия сайт и от гледна точка на user experience. Напомняме, че за Google са важни потребителите. Ако те са доволни от лесното и бързо използване на вашия сайт, Google също ще е.

Ето и още няколко неща от коментарите по темата:

Google: Съществуващи сайтове не отпадат от класирането само защото са с EMD

EMD или Exact Match Domain е име на домейн, което съответства точно на заявката, по която потребителите търсят в Google. Такъв пример се появи в Mastodon, където собственик на бизнес сподели, че името на неговия сайт отговаря на конкретна заявка. Това до скоро му е помагало да държи първи позиции в Google Search, но сега класирането на сайта му значително се е понижило.

От тази гледна точка, потребителят попита John Mueller дали причина за това може да е именно съответствието на заявката и името на сайта. В отговор John каза, че това няма как да се случи.

Той каза, че може да се дължи на ръчни действия, които ще са видими в Google Search Console. Ако няма такива, твърде вероятно е алгоритмите на Google да разглеждат сайта по друг начин във връзка с последните актуализации на Google, свързани със спам линковете и това кое съдържание е полезно и кое не е.

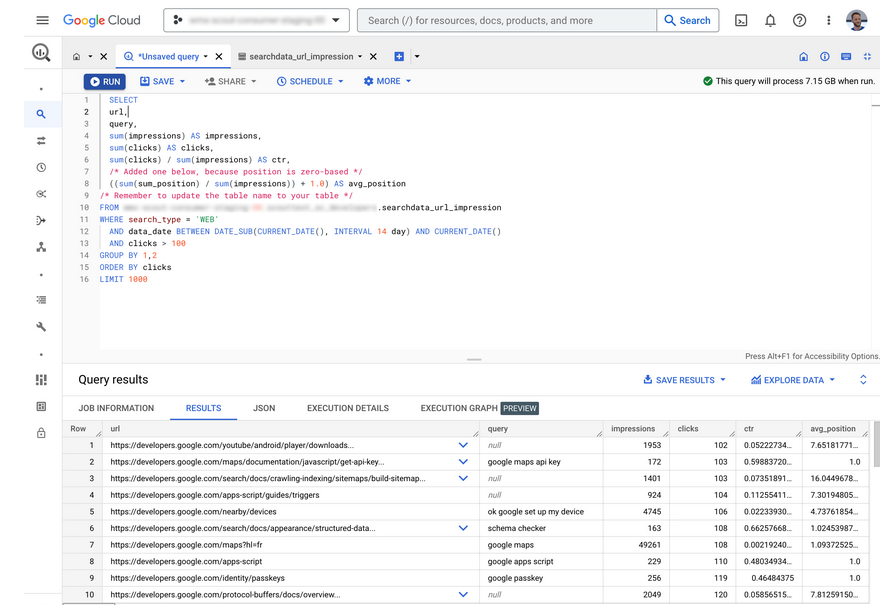

Google добави нова функция към Google BigQuery в Google Search Console

Google обяви, че има нова функция в Google Search Console, която позволява групово експортиране на данни. Това извличане ще включва всички данни, така че да можете да ги анализирате максимално ефективно. Тази нова функционалност на Google със сигурност ще бъде полезна на големите сайтове, които имат огромен брой страници и трафик на ден.

Google актуализира още две свои документации

Google направи актуализация на още две помощни документации, а именно тези за Google Discover и за Google Helpful Content System Page. Това, което пояснява в тях, е, че Google Discover използва голяма част от сигналите, които Google Search използва за класирането. Наред с това актуализацията за helpful content оказва влияние върху Discover.

Google Search Console актуализира контрола върху потребителите и разрешенията

Google Search Console актуализира контрола върху сигурността като промени работата на управление на потребители и разрешения. Целта е да се прехвърли старата версия на Webmaster Tools към новата, така че Google да закрие старата версия.

Част от новите функции, добавени в Google Search Console, включват:

- Разграничаване на верифицирани и делегирани собственици на сайт;

- По-лесно и бързо премахване на верифицирани собственици;

- Възможност за промяна на нивата на разрешения на делегираните собственици;

- Опция за преглед на токените за верификация за всички настоящи и предходни потребители;

- История на събитията, свързани със собствеността.

Играе ли някаква роля в класирането на сайта вграждането на местни отзиви, събрани от трети страни?

Такъв въпрос бе зададен на John Mueller и по-конкретно дали би помогнало за класирането на нашия сайт в Google, ако вграждаме в него отзиви за нас от Facebook, Bing, Google и други уебсайтове. В отговор John заяви, че това няма да окаже влияние върху класирането, като препоръча да не използваме структурирани данни за тези същите отзиви, събрани от сайтове на трети страни.

Какво споделя John Mueller от Google за пренаписване на съдържанието с ChatGPT

Завършваме обзора за февруари отново с темата за изкуствения интелект и ChatGPT. Все по-често SEO специалисти говорят за пренаписване на съдържание с ChatGPT, а не за създаване на такова с изкуствения интелект.

На голяма част от тези публикации John Mueller коментира по интересен начин, акцентирайки върху това дали си струва да се пренаписва и толкова лошо ли е съдържанието в дадения сайт, че да се обмисля пренаписването му.

Наред с това с това, със своите отговори подчертава върху това, че експертизата, която можем да имаме ние по дадена тема прави излишно използването на ChatGPT и много други.